筑波大学と東京農工大学などの研究グループは7月14日、コンピューターを利用して人間の歩き方から人の感情を読み取ることが可能であることが証明できたと発表した。将来は、サービスロボットが店舗に入ってくる客の感情を先読みして適切な対応を取るなど、人間とのコミュニケーション能力に優れたロボットの開発につながる。

■ロボットの“対応能力”向上に

筑波大の門根秀樹助教と東京農工大のベンチャー・ジェンチャン准教授が、仏コレージュ・ド・フランスのアラン・ベルトーズ名誉教授と共同で開発した。

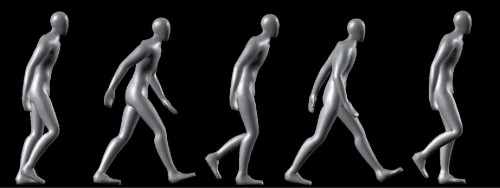

研究グループはまず、人間が歩き方の動作のうち、何に注目して歩行者の感情を読み取っているかを調べた。4人の演者に喜怒哀楽と恐れの5種類の感情を表現するよう歩いてもらい、その動きを単純なモデル画像にした。この画像の動きを被験者20人に見せて、歩行者がどんな感情を持って歩いているかを読み取ってもらった。

その結果、歩行速度、頭や胴体の姿勢などいくつかの評価点に注目して歩行者の感情を推測していた。さらに歩行速度や姿勢などを変化させると、被験者は歩行者の感情が変化したように感じることもわかった。

そこで、これらの評価点を基準に歩行者の姿勢からその感情をコンピューターで判断するアルゴリズム(計算処理の手順)を開発、判断の際の評価点の重みづけを最適化してより正しい判断ができるようにした。

研究グループは、「全体の動作ではなく一部の動きを見るだけで歩行者の感情を認識できることが示せた」として、今後はより複雑で多様な感情を認識する可能性を探ることにしている。

演者による感情表現のモーションキャプチャーデータから作成したモデル(提供:筑波大学)